Petr Talantov

Попался на глаза опубликованный еще в 2022 году отчет об эксперименте, в котором участвовали 73 исследовательские группы (161 ученый). Всем им предложили проверить одну и ту же гипотезу из области социальных наук, независимо проанализировав один массив данных. Значимой заинтересованности в том или ином результате, по мнению организаторов исследования, у участников не было.

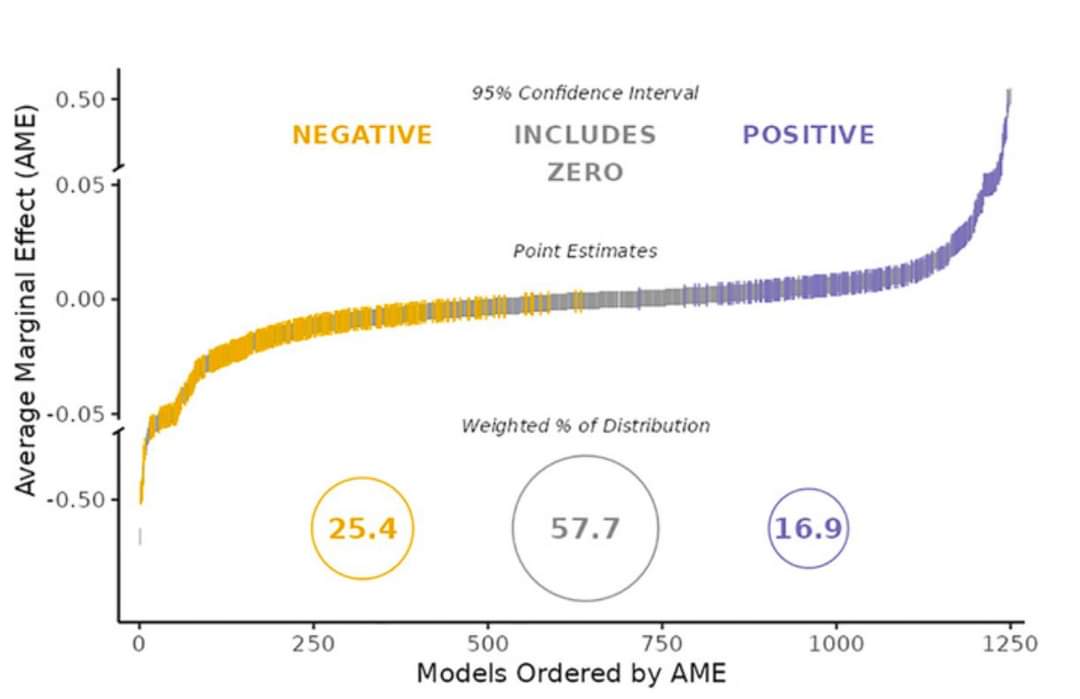

Всего исследователи использовали 1,261 моделей анализа, среди которых не оказалось ни одной пары полностью идентичных. Несмотря на общие исходные условия выводы на выходе получились разные: в 13.5% гипотезу сочли непроверяемой; в 60.7% - решили, что датасет ее опровергает; в 28.5% - что подтверждает. Разброс числовых значений размера эффекта см. на изображении.

Подобные работы уже были. Интересный нюанс этой в следующем. По идее, расхождения должны отражать принятые в ходе создания аналитической модели решения. Было идентифицировано 107 точек принятия решения, которые могли повлиять на результаты, но эти известные точки объясняли лишь относительно небольшую долю расхождений. Еще небольшой процент получилось отнести на счет параметров, связанных с самими исследователями - использованных статистических программ, уровня квалификации (знакомство с темой и методами) и исходного личного отношения к тестируемой гипотезе. Но подавляющее большинство расхождений (95.2%) остались без объяснения.

Из этого может следовать вот что. Когда обсуждаются проблемы воспроизводимости научных результатов, предполагается, что одна из основных причин - в систематических искажениях (байасе). Предотвратим систематическое искажение - получим правильный ответ. Иногда как причина звучит недостаточная квалификация исследователей - мол, неправильно проанализировали данные, если проанализируем правильно, то ответ будет верный. Но похоже на то, что предотвращение байаса само по себе не гарантирует воспроизводимость. И квалификация исследователей тоже, т.к не существует единственного безусловно верного методологического решения, которое знает и с точностью повторит любой достаточно грамотный специалист. Выглядит так, что даже небольшие и не всегда осознанные решения в ходе анализа данных могут существенно повлиять на результат.

Вобщем, авторы работы призывают к “эпистемической скромности”: не гоже, мол, делать громкие выводы из результатов единственной работы одной исследовательской команды. Даже если исследование методологически идеально, а команда нечеловечески беспристрастна.

Не знаю, до какой степени это применимо к медицинским исследованиям, особенно к экспериментальным. Но, в любом случае, призыв к “эпистемической скромности” был бы для них вполне уместен. Тем более, что с беспристрастностью в этой области сложнее, чем в социальных науках.

Доживем ли до тотально открытых данных и нового вида мета-анализов - синтеза результатов неоднократного анализа данных разными независимыми исследователями?

Comments (1)

Ой, у Петра Талантова есть отличная нон фикшн книга: "0,05. Доказательная медицина от магии до поисков бессмертия". Как раз на эту тему. Отличная книга, кстати.